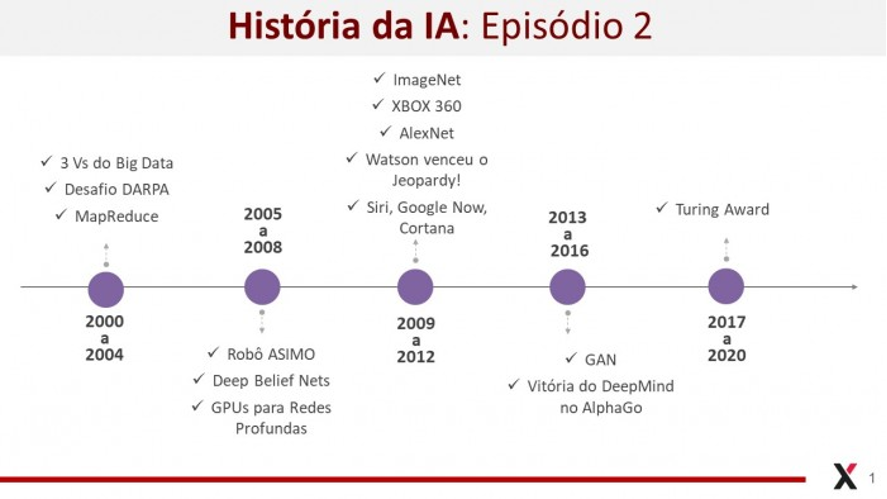

EPISÓDIO 02 – ONDE ESTAMOS: 2000 a 2020

(No nosso primeiro episódio trouxemos um breve relato sobre as origens da IA (1940 até 2000) focando alguns marcos históricos da área. Se você não tiver lido ainda, eu o(a) convido a iniciar sua leitura por lá antes de ler este post.)

As duas primeiras décadas do novo milênio inauguraram uma nova fase na IA, marcada por avanços expressivos e uma ampla penetração nos setores produtivos da economia.

A Agência de Projetos de Pesquisa Avançada em Defesa dos Estados Unidos (DARPA) lançou, em 2004, um Grande Desafio para o desenvolvimento de veículos autônomos e, em 2005, um veículo autônomo da Universidade de Stanford venceu o desafio dirigindo em um deserto por 131 milhas. Na mesma época, a Honda desenvolveu o robô humanoide ASIMO, capaz de andar e interagir com humanos, e os sistemas de recomendação ganharam muita expressão, principalmente como ferramentas de otimização da experiência de compra e personalização no comércio eletrônico.

No mesmo período tivemos evoluções importantes para a consolidação do que passou a ser conhecido como Big Data. É claro que a história do Big Data pode ser traçada a partir de uma época bem mais remota, porém focaremos aqui nos acontecimentos que promoveram a explosão da área. Em 2000 a Seisint Inc. desenvolveu uma estrutura distribuída de compartilhamento de arquivos e em 2001 o Grupo Gartner (na época chamado Grupo Meta) publicou um relatório definindo desafios e oportunidades de crescimento de dados como um elemento 3D, aumentando o volume, a velocidade e a variedade de dados. Esse elemento 3D ficou conhecido como os 3Vs do Big Data. Em 2004 o Google publicou um artigo sobre um processo denominado MapReduce e uma implementação em código aberto, chamada Hadoop, foi feita e teve ampla visibilidade. O Big Data também ganhou muita tração com o aumento do tráfego na web e o desenvolvimento da mobilidade, que promoveram um aumento exponencial na quantidade de dados semi- e não-estruturados gerados e armazenados, principalmente dados multimídia, como textos, imagens e vídeos.

Nessas duas décadas também não podemos deixar de citar os relevantes avanços da aprendizagem profunda (deep learning), cuja história inicial se confunde com a história das redes neurais já narrada no primeiro episódio dessa série. Cabe dar um pequeno passo atrás no tempo e destacar a proposição das redes recorrentes LSTM em 1997 por Sepp Hochreiter e Jurgen Schmidhuber, que mudaram a história da aprendizagem profunda. Em 2006 Geoffrey Hinton, Ruslan Salakhutdinov, Osindero e Teh publicaram um artigo propondo um algoritmo de aprendizagem rápida para as redes chamadas de deep belief nets. Em 2008 o grupo de pesquisa de Andrew Ng na Universidade de Stanford iniciou o uso de GPUs para treinar as redes profundas, aumentando em ordens de grandeza a velocidade de processamento das redes. Em 2009 outro grupo de Stanford, dessa vez liderado pela pesquisadora Fei-Fei Li, lançou a base de dados ImageNet, com 14 milhões de imagens rotuladas para uso da comunidade. Em 2011 Yoshua Bengio, Antoine Bordes e Xavier Glorot publicaram um artigo no qual eles mostraram que um tipo específico de função de ativação poderia resolver o problema numérico causado por valores muito baixos de gradiente, e em 2012 a AlexNet, uma implementação de redes convolucionais em GPUs, promoveu um salto de acurácia na performance das redes profundas aplicadas aos dados da Imagenet. Em 2014 surgiram as Redes Adversariais Generativas (GAN), propostas por Ian Goodfellow e no ano 2016 um modelo profundo de aprendizagem por reforço criado pela empresa Deepmind venceu o campeão mundial no jogo Alphago.

Na última década algoritmos e soluções de IA passaram a fazer parte de vários sistemas e produtos, resolvendo problemas complexos em áreas como reconhecimento de fala, robótica, diagnóstico médico, processamento de língua natural, logística e pesquisa operacional, detecção de anomalias (por exemplo, fraudes, crises, desastres, etc.) e muitas outras. Para ilustrar alguns desses desenvolvimentos, podemos citar que em 2011 o Watson da IBM venceu dois grandes campeões, com ampla margem, em um concurso de perguntas do programa Jeopardy!. Um ano antes a Microsoft havia lançado o Kinect para o console de jogos XBOX 360, baseado em uma tecnologia de aprendizagem de máquina para captura de movimentos. O Siri da Apple, o Google Now e a Cortana da Microsoft também surgiram como soluções de IA, mais especificamente de processamento de língua natural, com o objetivo de tirar dúvidas e fornecer recomendações para usuários.

Além do maior rigor científico da IA, alta disponibilidade de dados e a possibilidade de contratação de armazenagem e processamento sob demanda, quero destacar outro fator que contribuiu para a aceleração da área nos últimos anos. As empresas gigantes de tecnologia, como Google, Amazon, Microsoft, Apple, Facebook, Intel e outras, começaram a abrir parte de sua tecnologia para a comunidade. Frameworks, infraestrutura, toolkits, plataformas, etc., foram disponibilizados abertamente para que profissionais, empresas, empreendedores e instituições de ensino e pesquisa pudessem usar e avançar o conhecimento e a transferência de tecnologia. Keras, TensorFlow, NLTK, Spark, Scikit-learn, DAAL, Gensim, MongoDB e Tika são apenas alguns poucos exemplos desses.

Por fim, um aspecto marcante para o avanço da IA no novo milênio foi o fato de que a pesquisa na área começou a se aprofundar nos aspectos mais conceituais e teóricos, deixando de ser uma disciplina majoritariamente empírica e se tornando uma área mais científica. A aplicação de conhecimentos e formalismos matemáticos, principalmente álgebra linear, probabilidade e estatística, teorias econômicas e de programação matemática (pesquisa operacional), trouxeram maior rigor para a inteligência artificial. O maior reconhecimento científico para a IA veio com a premiação de Yoshua Bengio, Geoffrey Hinton e Yann Lecun em 2019 com o Turing Award para as pesquisas envolvendo aprendizagem profunda.