UMA BREVE HISTÓRIA DA IA: DE ONDE VIEMOS, ONDE ESTAMOS, PARA ONDE VAMOS!

(Recebi a missão de contar a história da Inteligência Artificial (IA), das suas origens até as tendências da área. Apesar de trabalhar com IA como pesquisador há 25 anos e como empreendedor há 15, sempre surge a pergunta sobre o formato dessa narrativa. Escolhi trazer para nossos leitores a história da IA baseada em alguns marcos relevantes para a área. É claro que essa narrativa deixará partes importantes de fora (porque a ideia não é fazer um tratado sobre a IA), mas espero trazer alguns acontecimentos e comentários que nos ajudem a entender a evolução da área, por que algumas coisas aconteceram e para onde ela caminha. Então, vamos lá!

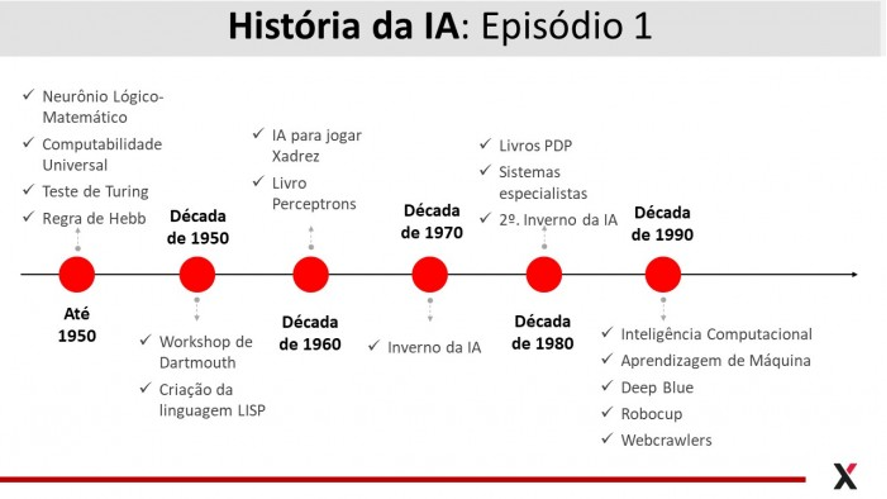

EPISÓDIO 01 – DE ONDE VIEMOS: 1940 a 2000

O cérebro continua sendo a mais fascinante estrutura biológica conhecida. A capacidade de criação e transformação do cérebro humano é superior à de qualquer outro, mas ainda somos incapazes de explicar muitas de suas funções básicas, como as emoções e a emergência das ideias. A forma como o cérebro funciona e toma decisões também foi a principal inspiração para o surgimento e desenvolvimento da IA. Nos primórdios da área, as iniciativas seguiam um de dois caminhos. Existia uma linha de trabalho que simplesmente tentava imitar a nossa maneira de tomar decisões baseadas em regras do tipo condição-ação, e outra forma que buscava construir estruturas matemático-computacionais inspiradas no cérebro e em outros sistemas naturais. A primeira linha denominamos de abordagens top-down, focada em programar nosso processo de tomada de decisão a partir de como acreditamos que ele funciona, e a segunda é bottom-up, ou seja, visa construir uma IA que seja capaz de aprender, de forma emergente, a tomar as decisões.

Em 1943 os pesquisadores Warren McCulloch & Walter Pitts propuseram o primeiro modelo matemático de um neurônio biológico capaz de realizar operações lógicas elementares, mas suficientes para transformá-lo num computador universal, ou seja, numa máquina capaz de realizar qualquer processamento que possa ser expresso por uma sequência de passos, um algoritmo. Essa computabilidade universal foi proposta por Allan Turing poucos anos antes, em 1936 em seu trabalho seminal sobre as Máquinas de Turing Universais. Em 1949 Donald Hebb propôs uma regra de aprendizagem aplicável a essas estruturas de processamento inspiradas no cérebro e em 1950 Turing publicou mais um trabalho relevante sobre inteligência computacional. No artigo intitulado Máquinas Computacionais e Inteligência, Turing introduziu o que hoje é chamado de Teste de Turing, que propõe que para uma máquina ser considerada inteligente, um humano não deve ser capaz de diferenciar entre a máquina e uma pessoa se eles estiverem dentro de salas fechadas se comunicando em linguagem natural com uma pessoa de fora da sala.

Ainda no final da década de 1940 e início da década de 1950, Norbert Wiener cunhou o termo cibernética, como o estudo do controle e comunicação nos animais e nas máquinas. Claude Shannon fez uma análise do jogo de Xadrez como um problema de busca e Isaac Asimov publicou as famosas três leis da Robótica (1. um robô não pode ferir um humano ou permitir que um humano sofra algum mal; 2. os robôs devem obedecer às ordens humanas, exceto quando essas ordens entrem em conflito com a primeira lei; e 3. um robô deve proteger sua própria existência, desde que não entre em conflito com as leis anteriores).

Dentre todos os eventos que contribuíram para o nascimento da área, a Escola de Verão em IA na Faculdade de Dartmouth em 1956 foi marcante e é considerado por muitos como a pedra fundamental da área. Esse workshop reuniu diversos pesquisadores pioneiros, como John McCarthy, Marvin Minsky, Nathanael Rochester e Claude Shannon. Durante os anos seguintes à escola de verão, os pioneiros criaram um superotimismo, com promessas ousadas de resolvedores universais de problemas (RUP) e robôs humanoides. Entretanto, a falta de recursos computacionais abundantes, a ausência de dados e o desconhecimento de algoritmos efetivos para a construção de modelos de IA acabaram promovendo o descrédito da área, que ficou conhecido como o inverno da IA. Durante esse período, os recursos para pesquisa em IA ficaram escassos e a credibilidade do seu real potencial inovador ficou abalada.

Apesar disso, avanços importantes ocorreram, como a escrita do primeiro programa para jogar Xadrez por Arthur Samuel no início da década de 1960, a criação da linguagem de programação Lisp por John McCarthy em 1958 e a publicação do livro Perceptrons por Marvin Minsky e Simon Papert em 1969.

O período de estagnação da IA durou até início da década de 1980, quando alguns acontecimentos novos marcaram a área. Os dois volumes intitulados Processamento Paralelo e Distribuído (Parallel Distributed Processing), organizados por James McClelland e David Rumelhart, concatenaram muitos trabalhos envolvendo, principalmente, redes neurais que permitiram à área dar um grande salto. Dentre esses podemos destacar a releitura do algoritmo para treinamento dos modelos de redes multicamadas com propagação positiva, popularmente conhecido como algoritmo de backpropagation, e algoritmos para treinamento de redes recorrentes e não-supervisionadas. Esses volumes ainda trouxeram os trabalhos que permitiram o surgimento das redes capazes de gerar representações distribuídas de palavras e modelos recentes de redes profundas.

(Sempre me chama a atenção como, às vezes, algumas ‘pérolas da ciência’ ficam escondidas na literatura e só são descobertas ou desenvolvidas anos mais tarde.)

Entre meados e final da década de 1980, a IA passou por um novo período de baixa, que ficou conhecido como o segundo inverno da IA, principalmente devido ao declínio do uso da linguagem LISP pela indústria e a incapacidade de efetividade dos sistemas especialistas (abordagens top-down).

Nos anos que antecederam a virada do milênio houve uma explosão na pesquisa em IA, principalmente as técnicas que passaram a ser conhecidas como inteligência computacional, que inclui as redes neurais artificiais, os algoritmos evolutivos e os sistemas fuzzy. Surgiu, na mesma época, a aprendizagem de máquina (machine learning), caracterizada pelos algoritmos focados na aprendizagem a partir de dados. Coincidentemente, essas duas áreas surgiram oficialmente no ano 1994 com a publicação de livros e a criação de grandes eventos técnico-científicos. Mas a diferença entre as nomenclaturas é assunto para outro post.

Vamos fechar esse primeiro episódio listando mais alguns avanços significativos em IA no período, como realidade virtual, robótica comportamental, IA aplicada a jogos, a vitória do Deep Blue sobre o Garry Kasparov, a criação do RoboCup (olímpiadas de futebol de robótica) e, claro, o surgimento dos web crawlers como ferramentas para recuperação de informação em ambientes web.

Nos vemos no próximo episódio, até breve!